在OpenAI的ChatGPT横空出世后,新一轮AI浪潮就此引爆,英伟达(NVDA.US)、台积电(TSM.US)等公司也上演了一出出“大象起舞”的好戏。

而伴随着AI芯片需求的井喷,HBM芯片的市场空间也在大幅增长,成为了一条黄金赛道。

HBM芯片是什么?

AI芯片需要处理大量并行数据,主要是英伟达的GPU能爆卖的根本原因。

AI芯片要求高算力和大带宽,算力越强、每秒处理数据的速度越快,而带宽越大、每秒可访问的数据越多,算力强弱主要由AI芯片决定,带宽由存储器决定,存力是限制AI芯片性能的瓶颈之一。

HBM(高带宽存储器)是GDDR的一种,定位在处理器片上缓存和传统DRAM之间,兼顾带宽和容量,较其他存储器有高带宽、低功耗、面积小的三大特点。目前面临的一个问题是,HBM的价格曾一度远超普通DRAM,这使得它在市场中一度陷入尴尬的境地。

而AI浪潮的到来给HBM带来了“福音”,立体堆叠的HBM完美契合大模型的要求。

在AI场景中,英伟达首先设计完GPU,然后采购海力士的HBM,最后交由台积电利用CoWoS封装技术将GPU和HBM封装到一张片子上,最终交付给AI服务器厂商。

由此可见,在此过程中,GPU、GPU代工商以及HBM生产商之间形成了紧密而稳固的合作关系,彼此之间的联系十分紧密。

HBM供不应求,海力士、三星积极扩产

如今AI领域发展得如火如荼,HBM的市场规模也随之水涨船高。

据悉,当下主流AI训练芯片均使用HBM,一颗GPU配多颗HBM。其中,英伟达1颗H100配5颗HBM3、容量80GB,H200使用6颗HBM3E(全球首颗使用HBM3E的GPU)、容量达144GB。

3月18日,英伟达宣告称,公司的B100和B200使用192GB(8个24GB8层HBM3E),HBM用量进一步提升。

此外,超威半导体(AMD.US)的MI300系列、谷歌的TPU系列均使用HBM。

在具体的市场规模方面,据了解,在AI没有爆发之前,市场预测全球HBM将平稳增长至一个100亿美元的市场。

而根据新的测算,2023年HBM市场规模为40亿美元,预计2024年增长至150亿美元,到2026年增长至接近250亿美元,年复合增速高达80%以上。

值得注意的是,于2023年11月,海力士CEO称,预计到2030年,海力士每年HBM出货量将达到1亿颗,隐含产值规模将接近300亿美元,假设届时海力士市场份额为50%,则整个市场空间将在500亿美元左右。

在竞争格局方面,HBM的供应由SK海力士、三星电子和美光科技(MU.US)三大厂商垄断,2022年三者的份额分别为50%、40%、10%。

其中,SK海力士是HBM先驱,HBM3全球领先,与英伟达强绑定、是英伟达主要HBM供应商,三星电子紧随其后,美光科技则正在积极追赶中,HBM3E进度直逼SK海力士。

目前,当下的HBM市场处于供不应求状态。

而三家大厂垄断市场,彼此之间的竞争也比较激烈。其中,SK海力士和三星电子均计划在2024年将HBM产能提升2倍以上。

另外,SK海力士已在今年3月宣布开始量产8层HBM3E,3月底开始发货;美光科技则跳过HBM3直接做HBM3E,已于2月底宣布量产8层HBM3E;三星电子则在今年2月底发布12层HBM3E。

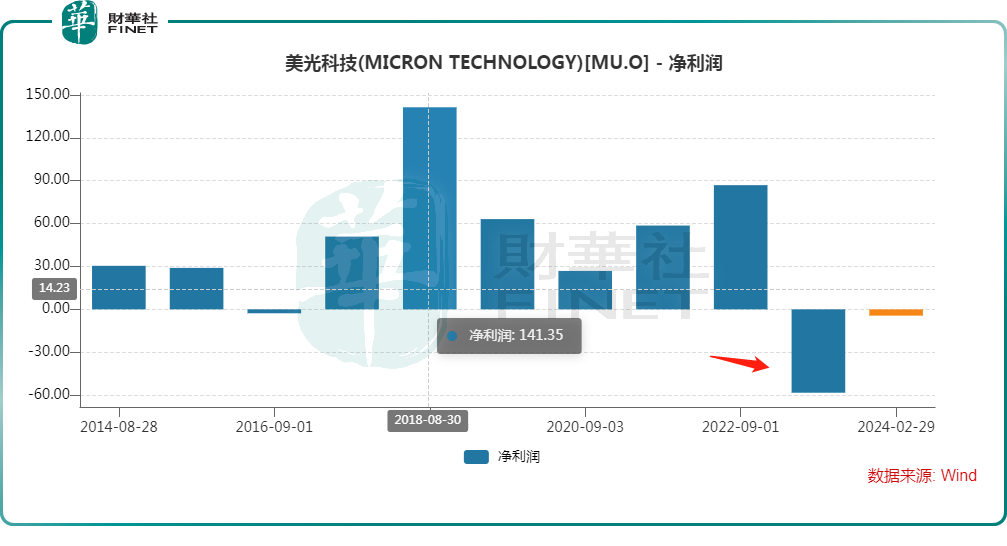

需要指出的是,近两年芯片领域一片“寒意”,SK海力士、三星电子和美光科技一度遭遇业绩暴降,甚至出现巨亏的情况,如下图所示。

据美光科技披露了2024财年第二财季(截至2月29日)的业绩显示,在美国公认会计准则下(GAAP),期内美光科技实现营收58.24亿美元,同比增长57.70%;净利润为7.93亿美元,同比、环比均实现扭亏;摊薄后每股收益为0.71美元;非公认会计准则净收益为4.76亿美元,摊薄后每股收益0.42美元。

美光科技CEO认为,在AI带来的机遇中,美光是半导体行业最大的受益者之一。

之所以这么说,是因为美光科技于今年2月26日宣布开始量产HBM3E高带宽内存(第五代HBM,是市场针对AI应用的最高规格DRAM产品)。

在第二财季电话会上,美光科技披露,公司新品HBM3E芯片今年的产能已全部卖光,明年的大部分产能也已经被预定。

而HBM3E将供给英伟达(NVDA.US)的AI芯片H200GPU。

美光科技还预计,2024财年,HBM系列产品将为公司带来数亿美元的营收,甚至有望比肩公司第二大业务—NAND业务。

美光科技的情况如此,SK海力士和三星电子也都受益于HBM产品的爆发。

尾语

从目前的情况来看,伴随着AI芯片需求的暴增,HBM产品具有极强的稀缺性,将助力存储芯片大厂迎来业绩回升,相关领域是否存在投资机会值得关注。

更多精彩內容,請登陸

財華香港網 (https://www.finet.hk/)

現代電視 (http://www.fintv.com)